본 글은 아래 영상을 기반으로 작성하였습니다.

https://www.youtube.com/watch?v=GbCAwVVKaHY&list=PLQASD18hjBgyLqK3PgXZSp5FHmME7elWS&index=10

# Variational Autoencoders(VAE)

AE 같은 경우에는 encoder가 중요한 반면, VAE는 decoder가 더 중요하다.

즉, AE는 차원을 축소하는 게 중요하고, VAE는 새로운 데이터를 생성하는 것이 중요하다.

encoder같은 경우에는 바로 를 구하는게 아니라

평균 와 분산 를 뽑아낸 후 샘플링해서 를 구한다.

그리고 여기서 sampling하는 과정에서 Reparameterization Trick 을 사용해야 backpropagation이 가능하다.

loss function은 2가지의 합으로 이루어진다. (1) Reconstruction Error (2) Regularization

(1)

일단, input이 그대로 복원될 수 있게 하는 Reconstruction Error가 최소화될 때

가 베르누이 분포를 따른다고 가정하면 Cross Entropy로 표현할 수 있다.

(2)

또한, encoder를 통과한 값이 normal distribution을 따라야 하기 때문에 KL divergence 식을 쓰는데

이는 를 의미하고 둘 사이의 차이를 최소화하기 위한 식이다.

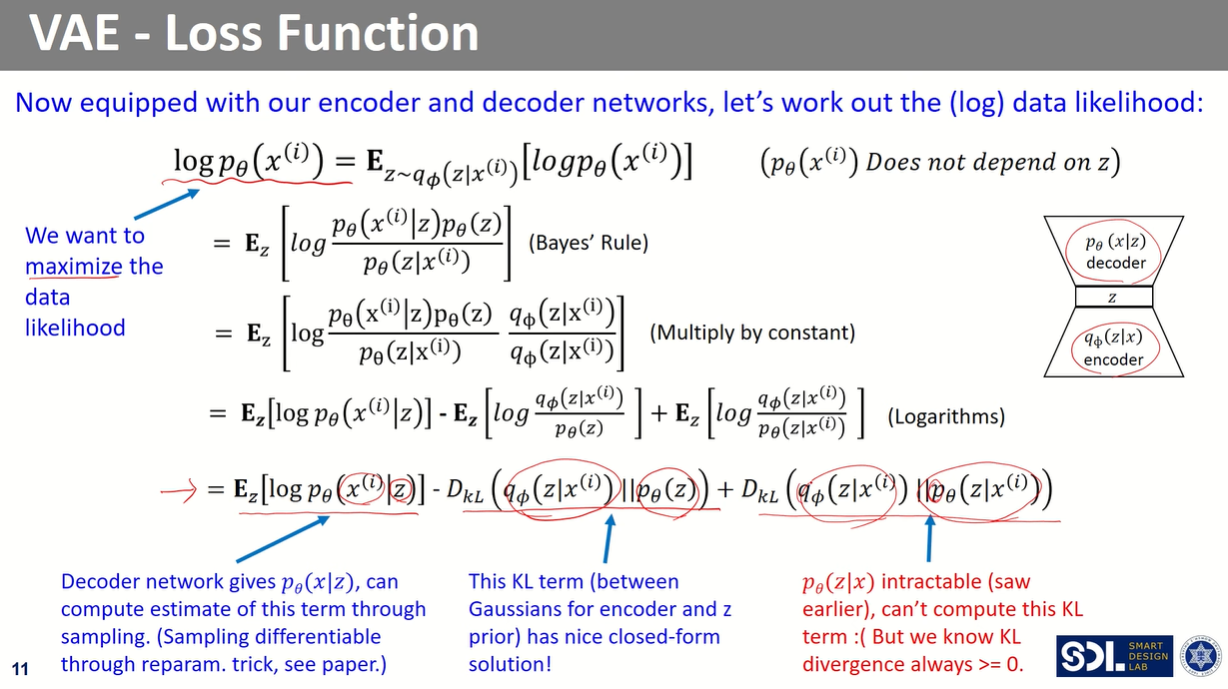

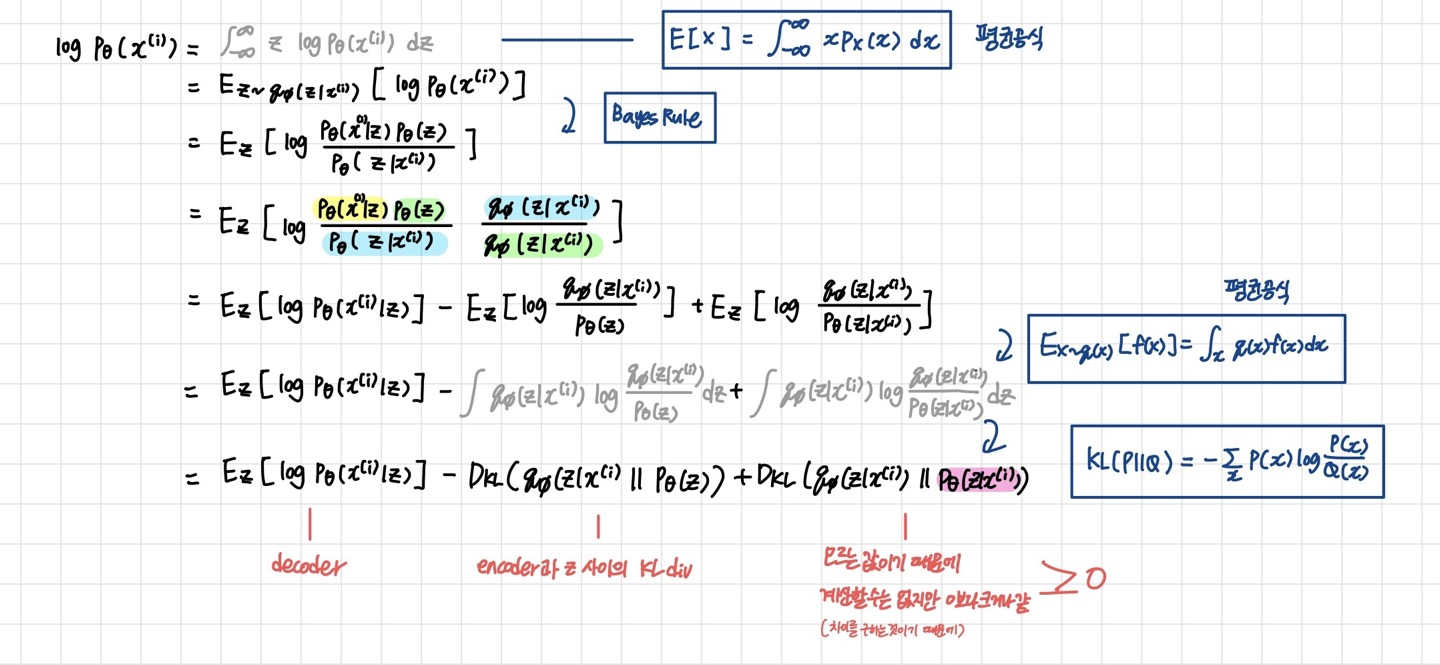

# Loss Function

일단 우리가 알고 싶은 것은 최적화된 인 이다

이를 어떻게 훈련시킬 수 있을까?

p_{\theta}(x|z)$는 decoder NN이라고 했을 때

z는 무한하기 때문에 모든 z에 대해 적분할 수 없어서 를 구할 수 없다.

그래서 다른 식으로 구해보기로 했다.

만약 를 구해보면 어떨까?

이 식을 다시 써보면, 인데

여기서 다시 를 모르기 때문에 구할 수 없다.

그럼 어떻게 해결할까? decoder를 구하기 위해 encoder를 추가로 정의하기로 했다.

즉, 여기서는 decoder를 modeling하기 위해서 encoder 를 정의한 것이다.

그리고 이 는 에 근사하는 값이다.

핵심은 원래 decoder만 있으면 되는데 이를 학습시키기 위해서 encoder의 도움을 받은 것이다.

구체적인 풀이과정은 위의 식과 같다.

따라서, 를 최대화할 때, 를 lower bound로 설정하는 것이다.

결론적으로는,

를 최대화해주는 와 을 찾으면 된다.

이때 는 은 encoder 속의 W,b이고, decoder 속의 W,b이다.

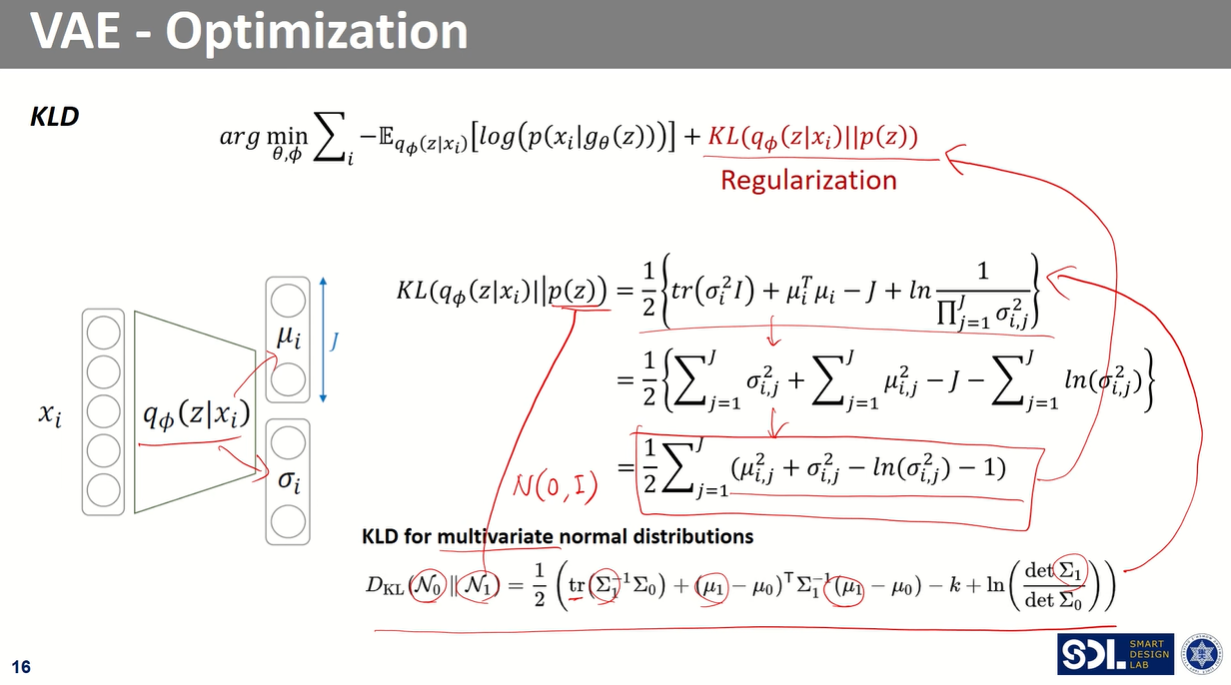

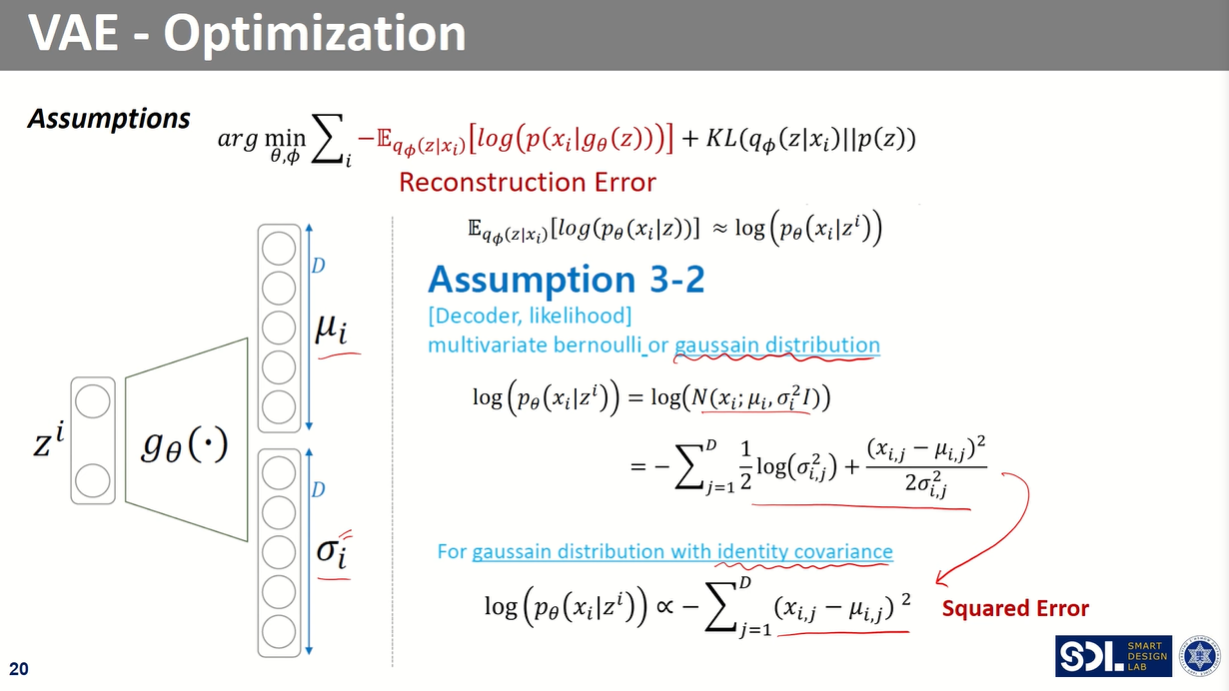

# Optimization

Regularization을 구하는 식을 구해보자.

이때 위와 같은 가정 2개를 설정한다.

100% 이해된건 아닌거 같은데 일단 넘어갈게..

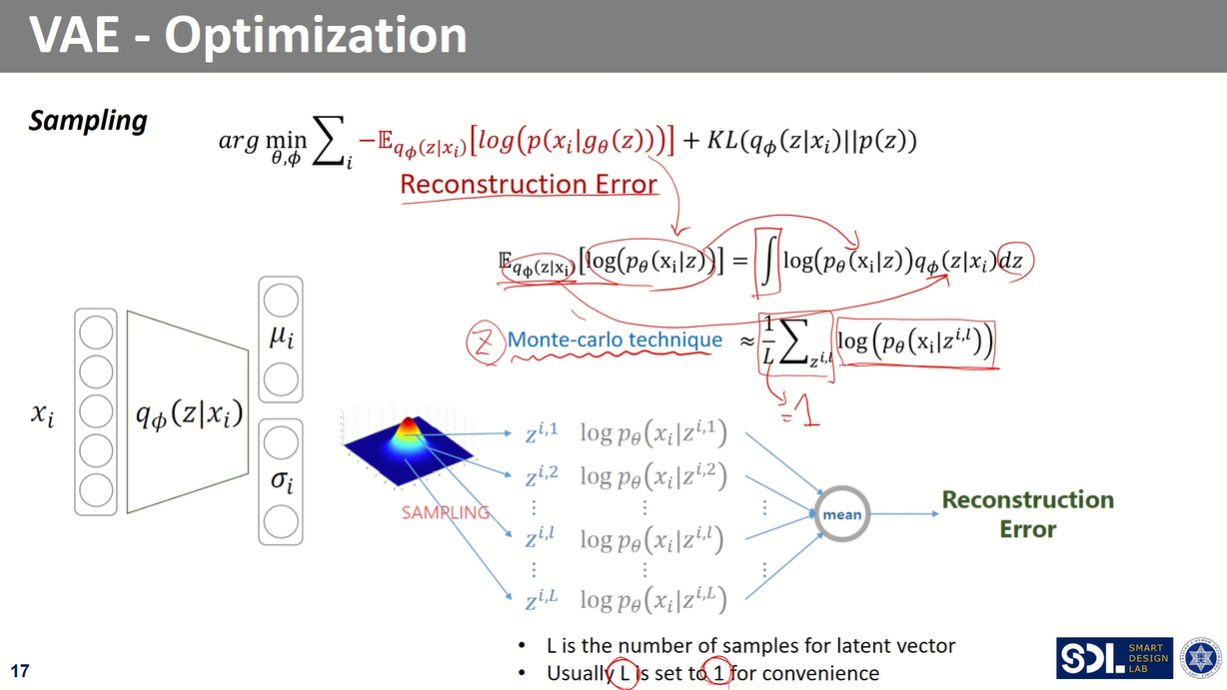

L을 1이라고 가정을 해버림. random하게 딱 하나의 sampling을 했다고 가정

핵심은, 확률 분포를 베르누이라고 가정해서 loss 구할 수 있음

확률 분포를 가우시안으로 가정하면 다음과 같은 loss를 구할 수 있음

위와 같이 Decoder의 분포를 베르누이가 아닌 가우시안으로도 표현할 수도 있음

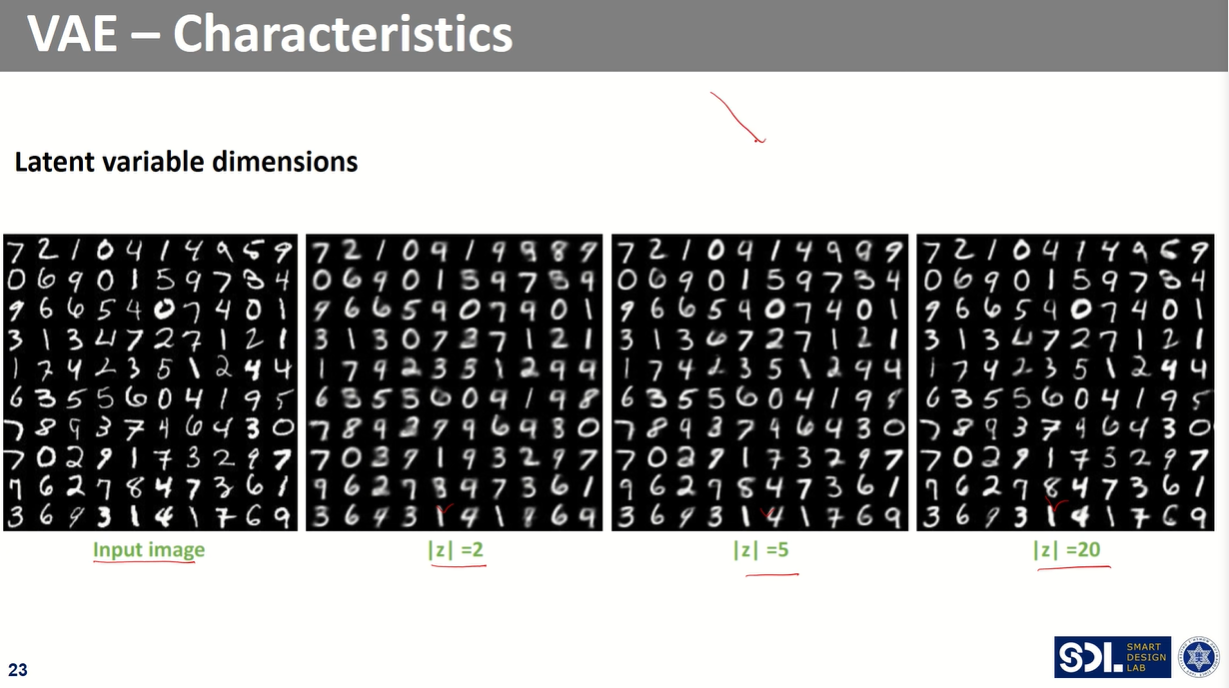

당연히 latent space의 차원을 늘릴수록 이미지가 잘 복원되는 것을 볼 수 있음

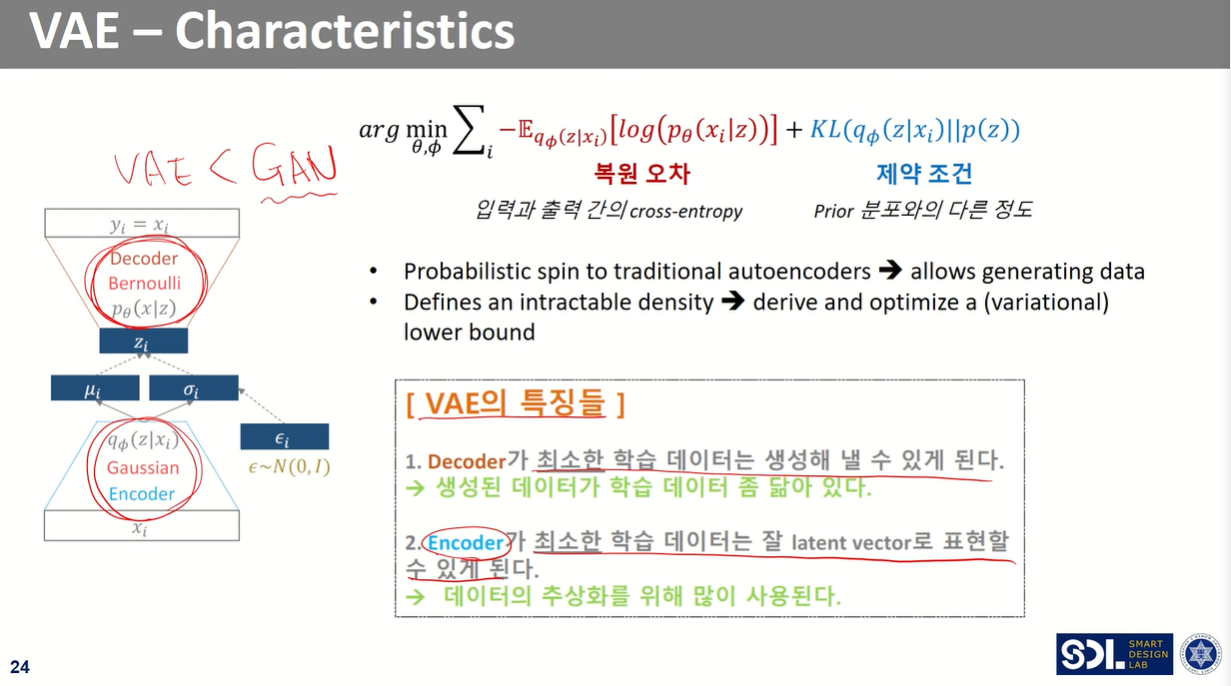

다음 챕터의 GAN이 VAE에 비해 새로운 데이터들을 더 잘 생성한다.

따라서, VAE는 decoder 때문에 제안된건데 실제 연구에서는 encoder를 많이 사용함

그리고 코드는 regularization과 reconstruction error를 개선하는 방식으로 짤 수 있음

'📚 Study > AI' 카테고리의 다른 글

| Diffusion Model 수학이 포함된 tutorial (1/2) (0) | 2024.07.17 |

|---|---|

| [딥러닝과 설계] GAN (0) | 2024.07.11 |

| [딥러닝과 설계] Autoencoder & Anomaly Detection (1) | 2024.07.10 |

| [딥러닝과 설계] Unsupervised Learning 비지도학습기초 (1) | 2024.07.10 |

| [cs231n] Variational Autoencoders (VAE) (0) | 2024.07.09 |